英伟达Blackwell芯片曝出发热问题,需要重新设计机架并可能导致客户延误。

据The Information周日报道, 英伟达下一代Blackwell处理器安装在高容量服务器机架时面临着过热的挑战。发热问题导致了设计变更和延迟,并引起了Google、Meta 和Microsoft等客户的担忧,他们担心自己是否能按时部署Blackwell服务器。

此前,由于芯片出现设计缺陷,英伟达已不得不将Blackwell GPU的生产和交付推迟至少一个季度。这两起事件凸显了英伟达在满足客户对AI硬件的需求方面所面临的困难。

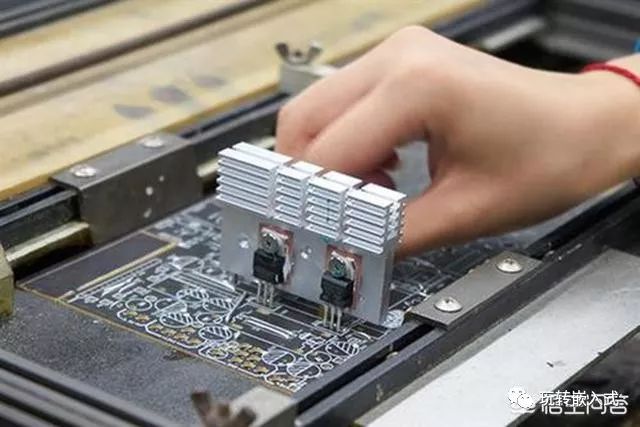

新的服务器机架之所以意义重大,是因为其集成了72个英伟达 AI 芯片,预计每机架功耗高达120kW。由于过热会限制GPU性能并有损坏组件的风险,该问题导致英伟达多次重新评估其服务器机架的设计,

针对延迟和过热问题,英伟达已指示其供应商对机架进行几项设计更改,以解决过热问题。该公司与供应商和合作伙伴密切合作,开发工程修订版以改善服务器冷却。虽然这些调整对于如此大规模的技术发布来说是标准做法,

高管们表示,他们至少需要几周的时间来测试系统并解决可能出现的问题,尤其是考虑到其新颖的设计和前所未有的复杂性。据一位参与设计的人士称,一些客户(如微软)计划通过更换一些组件来定制Blackwell 机架,以适应他们的数据中心。

与此同时,客户也在考虑其他选择。一家订购了机架的云计算公司的高管表示,Blackwell的问题导致该公司考虑购买更多英伟达当前一代 Hopper 芯片。

分析表示,客户决定购买更多Hopper芯片,可能会提高英伟达的短期收益,分析师和投资者估计 Hopper 系列的利润率更高。但这对英伟达未来的收入增长来说可能不是一个好兆头,已经转向 Hopper芯片的客户可能不会订购那么多Blackwell芯片和NVLink服务器。

分析表示,客户决定购买更多Hopper芯片,可能会提高英伟达的短期收益,分析师和投资者估计 Hopper 系列的利润率更高。但这对英伟达未来的收入增长来说可能不是一个好兆头,已经转向 Hopper芯片的客户可能不会订购那么多Blackwell芯片和NVLink服务器。

老黄深夜炸场,世界最强AI芯片H200震撼发布!性能飙升90%,Llama 2推理速度翻倍,大批超算中心来袭

英伟达发布了目前世界最强的AI芯片H200,性能较H100提升了60%到90%,还能和H100兼容,算力荒下,大科技公司们又要开始疯狂囤货。 H200性能直接提升60%到90%,与H100互相兼容,使用H100训练/推理模型的企业可以无缝更换成最新的H200。 AI公司们正为寻找更多H100而焦头烂额,英伟达的高端芯片价值连城,已经成为贷款的抵押品。 H200系统预计将于明年二季度上市,英伟达还会发布基于Blackwell架构的B100,并计划在2024年将H100的产量增加两倍。 H200基于Hopper架构,配备英伟达H200 Tensor Core GPU和先进的显存,可以为生成式AI和高性能计算工作负载处理海量数据。 H200拥有高达141GB的显存,与A100相比,容量几乎翻了一番,带宽也增加了2.4倍。 H200的发布让性能飞跃又升了一级,直接让Llama2 70B模型的推理速度比H100提高近一倍。 H200基于与H100相同的Hopper架构,除了新的显存功能外,还具有与H100相同的功能,例如Transformer Engine,可以加速基于Transformer架构的LLM和其他深度学习模型。 HGX H200采用英伟达NVLink和NVSwitch高速互连技术,8路HGX H200可提供超过32 Petaflops的FP8深度学习计算能力和1.1TB的超高显存带宽。 当用H200代替H100,与英伟达Grace CPU搭配使用时,就组成了性能更加强劲的GH200 Grace Hopper超级芯片。 H200在处理高性能计算的应用程序上有20%以上的提升,推理能耗直接腰斩,大幅降低用户的使用成本。 英伟达更是在官方公告中宣布了全新的H200和B100,将过去数据中心芯片两年一更新的速率直接翻倍。 德国尤里希超级计算中心、日本先进高性能计算联合中心、德克萨斯高级计算中心和伊利诺伊大学香槟分校的美国国家超级计算应用中心以及布里斯托大学都将采用英伟达GH200构建超级计算机,提供总计约200 Exaflops的AI算力,推动科学创新。 GPU竞赛进入了白热化阶段,面对H200,AMD的计划是利用即将推出的大杀器——Instinct MI300X来提升显存性能,MI300X将配备192GB的HBM3和5.2TB/s的显存带宽,这将使其在容量和带宽上远超H200。 英特尔也计划提升Gaudi AI芯片的HBM容量,并表示明年推出的第三代Gaudi AI芯片将从上一代的 96GB HBM2e增加到144GB。 H200的价格暂时还未公布,一块H100的售价在美元到美元之间,训练AI模型至少需要数千块。 AI公司和科技公司们已经开始为即将到来的算力风暴做准备,预计明年第二季度H200上市将引发新的风暴。 AI芯片竞赛进入白热化,三巨头英伟达、AMD、英特尔在AI芯片领域展开激烈竞争。 GPU的价格和性能成为科技公司和AI公司关注的焦点,H200的发布预示着AI芯片领域的新一轮竞争即将开始。

英伟达最先进的ai芯片

英伟达最先进的AI芯片是Blackwell GPU。 Blackwell GPU是英伟达在AI芯片技术领域的最新突破,于2023年3月18日由英伟达CEO黄仁勋在GTC大会上正式发布。 这款芯片被视为英伟达迄今为止最强大的AI处理器,其设计理念和技术特性均体现了英伟达在人工智能领域的深厚积累与前瞻视野。 从技术细节来看,Blackwell GPU采用了台积电的4纳米工艺,集成了高达2080亿个晶体管,这一数字远超其前身H100的800亿个晶体管。 其显著特点之一是提供了高达20 petaflops的FP4八精度浮点运算能力,相比H100的4 petaflops有了显著提升。 这意味着Blackwell GPU在处理复杂的AI算法和模型时,能够提供前所未有的计算速度和效率。 此外,Blackwell GPU的推出还伴随着一系列软硬件生态系统的更新。 英伟达不仅提供了强大的硬件基础,还通过其CUDA平台、NVLink技术以及新推出的NIM微服务,为开发者构建了一个全面、高效的AI计算环境。 这些技术的结合使得Blackwell GPU在大规模数据处理、深度学习训练与推理等方面表现出卓越的性能,进一步巩固了英伟达在AI芯片市场的领先地位。 总的来说,Blackwell GPU的发布是英伟达在AI技术领域的又一重要里程碑。 它不仅代表了当前最先进的AI芯片技术,更预示着未来人工智能发展的无限可能。 通过持续的技术创新和生态系统构建,英伟达正引领着AI芯片技术的发展潮流,为全球范围内的科研工和企业用户提供了强大的计算支持。

英伟达下一代RTX 50系显卡细节泄露,代号Blackwell,AMD挑战王者任重道远

英伟达下一代GPU Blackwell产品线细节泄露,预计于2024年底或2025年面世,其内部开发代号分别为GB202、GB203、GB205、GB206、GB207。 根据国外媒体的分析,GB202将服务于高端市场(如GeForce RTX 5090、GeForce RTX 5090 Ti),GB203则针对主流配置(例如GeForce RTX 5080、GeForce RTX 5070 Ti 和 GeForce RTX 5070),GB205则针对「甜品卡」部分(GeForce RTX 5060 Ti、GeForce RTX 5060)。 这一策略有助于NVIDIA充分利用所有GB203芯片。 相比之下,Chiphell的网友aibo则认为,GeForce RTX 5070将采用GB205核心。 从代号之后的CUDA核心数可以看出,代表英伟达出战中端市场的X04的产品的性能,一般是产品线中最高端产品的5成到7成之间。 在英伟达最近两代显卡产品线中,对应X04这个级别的产品型号为XX70。 然而,X02和X04之间的空档在推出3款显卡时略显不够,导致了XX80和XX70Ti之间的重叠,无形中挤压了XX80系列的生存空间。 如果下一代显卡中,原先由X04这个级别的GPU覆盖的XX70的市场,因为X04的取消,而由X03级别的产品「向下兼容」,那么XX70的性能提升可能比3070和4070之间的提升要大。 但如果X05级别的GPU作为XX70这一档推出,性能相比前两代XX70之间的提升就较小。 然而,这些信息仍为泄露信息,最终产品的性能还需官方确认。 关于消费者的好消息是,50XX系列的GPU可能会重新采用512位的显存位宽,相比40XX系列最高位宽只有384位,提升高达1/3。 更大的显存位宽意味着新一代GPU的性能提升会很明显,缓解了上两代中被诟病的窄带宽问题。 如果显存位宽真的被提到512位,那么这一代显卡所有型号的带宽问题都将得到大大改善,从而带来整体上性能的大幅提升。 此外,英伟达在SIGGRAPH发布会上发布了基于ADA Lovelace核心的工作站级别的显卡,包括RTX 5000、RTX 4500和RTX4000。 这些显卡在性能上相比前一代提升巨大,很多测试提升都超过了100%。 RTX 5000配备了32GB显存,个CUDA核心,400个Tensor核心,100个RT核心;RTX 4500配备了24GB显存,7680个CUDA核心,240个Tensor核心,60个RT核心;RTX 4000配备了20GB显存,6144个CUDA核心,192个Tensor核心,48个RT核心。 英伟达在专业领域表现突出,AMD虽然在8月初发布了两款专业级GPU,但其性能与英伟达仍有较大差距。 AMD需要尽快发力,以应对几乎完全被英伟达「绑架」的AI算力和数据中心市场。